Information

- Title: CNNs with Multi-Level Attention for Domain

Generalization

- Author: Aristotelis Ballas, Christos Diou

- Institution: Harokopio University of Athens

- Year: 2023

- Journal: ICMR ’23 (ACM International Conference on Multimedia Retrieval)

- Source: Arxiv, PDF

- Cite: Ballas A, Diou C. CNNs with Multi-Level Attention for Domain Generalization[C]//Proceedings of the 2023 ACM International Conference on Multimedia Retrieval. 2023: 592-596.

- Idea: 提出使用多头自注意力提取CNN中不同层分类相关的特征

1 | @inproceedings{ballas2023cnns, |

Abstract

提出了一种模型结构,使用注意力机制采集卷积网络中的多层次信息用于域泛化的分类任务。

Method

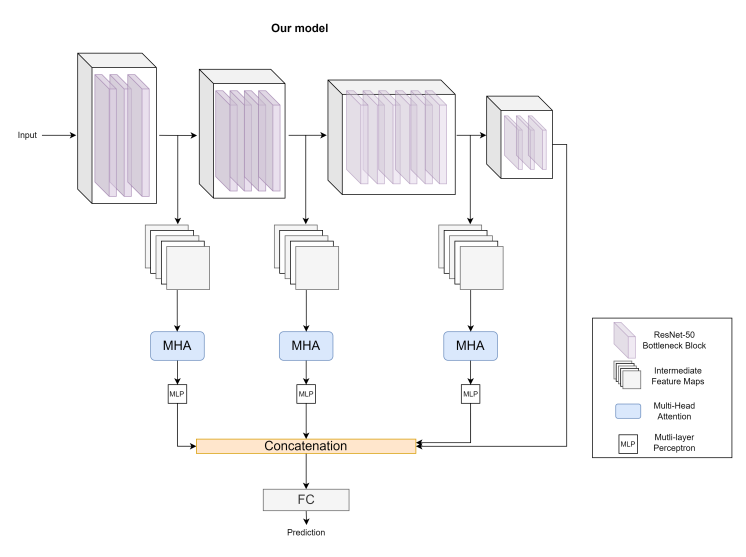

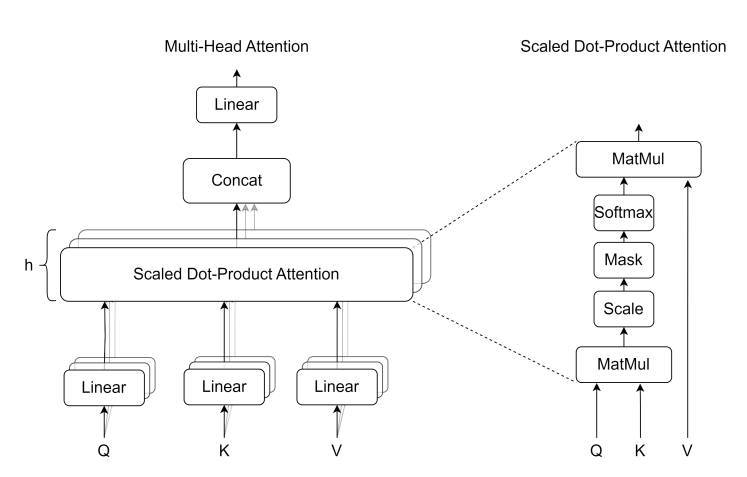

网络结构如上图所示,从不同层之间提取中间特征图,然后送入 Transformer 结构中的多头自注意力结构,后接一个 MLP 层,最后将不同层之间的特征连接起来送入分类器用于分类,这么做的目的是希望提取与分类相关的特征而不是域相关的特征。下图是文中使用的多头自注意力机制:

Experiment

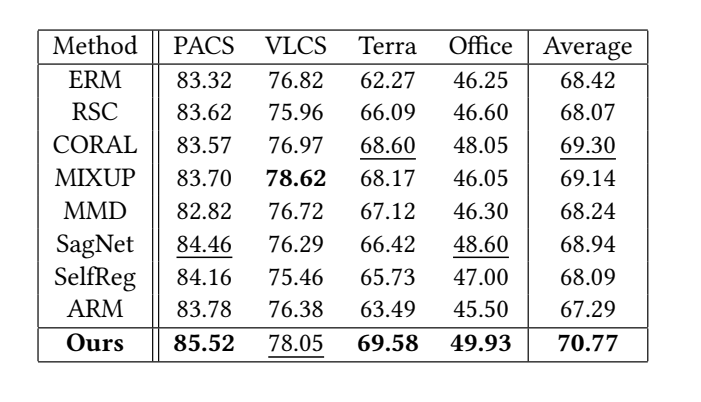

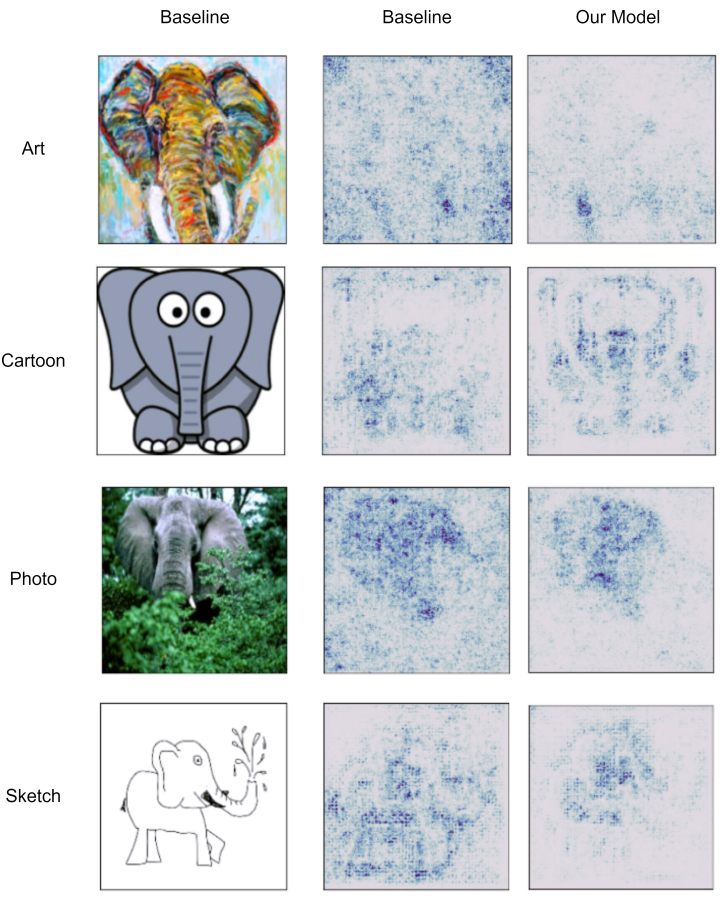

实验结果部分就是与其他方法在几个常用域泛化数据集上进行的比较,还有个 Saliency map 的可视化实验

Saliency map 的可视化图中颜色越深的点表面在模型分类中越重要

Conclusion

结论部分有提到该方法的不足之处是时空开销很大,后续可能会有改进吧。

总的来说感觉是个很简单的工作,创新点不是特别突出,是简单的将不同的方法糅合到一起,文章中的描述也比较简单,供参考

如有错漏,欢迎指正!如果对你有帮助的话,请给我点个赞吧~

欢迎前往 我的博客 查看更多笔记