Information

- Title: Domain Generalization: A Survey

- Author: Kaiyang Zhou, Ziwei Liu, Yu Qiao, Tao

Xiang, and Chen Change Loy

- Institution: 新加坡南洋理工大学

- Year: 2022

- Journal: IEEE Transactions on Pattern Analysis and Machine Intelligence

- Source: IEEE, Arxiv

- Idea: 综述

1 | @article{zhou2022domain, |

Abstract

是一篇关于域泛化(DG, Domain generalization)的综述文章,给出了 DG 的定义,对已有的工作进行了一些展示和总结

Introduction

首先,我们在机器学习中有一个不可忽视的问题,域偏移(domain shift),即训练集和测试集分布不一致,而我们的模型通常是以独立同分布(iid)为假设前提的,这就导致当模型遇到与源数据分布不一致的数据时性能会大幅度下降,一个直接的解决方案是采集一些目标域的数据用在训练中,问题此时就转变为域适应,但很多时候我们并不能直接采集到目标域的数据用于模型训练,例如处理数据流,我们需要模型具有可扩展的能力。因此我们引入了域泛化,即在一个或多个不同的源域训练模型时期在面对具有域偏移的问题时能保持相对较好的性能。

目前解决域偏移的方法有:训练模型学习域不变的特征、通过元学习是模型学会域偏移、通过域合成生成数据。

Background

History

- 域泛化区别与迁移学习和域适应的最重要一点是考虑了目标数据不可访问

- 历史没什么好说的,就是说医疗领域我们不能每个患者的数据都去收集任何微调模型吧?在视觉领域换个数据集原本很好的模型性能十不存一。

Definition

前面有些符号定义,写论文的时候倒是可以参照一下

有两种DG,分别是单源DG和多源DG。

- 多源DG,即有多个不同但相关的源域可用,可以利用多个源域来学习不同分布中不变的特征,使得模型对不可见的域也能有较好的泛化性。

- 单源DG,假设训练数据是同质的,单源算法不需要域标签

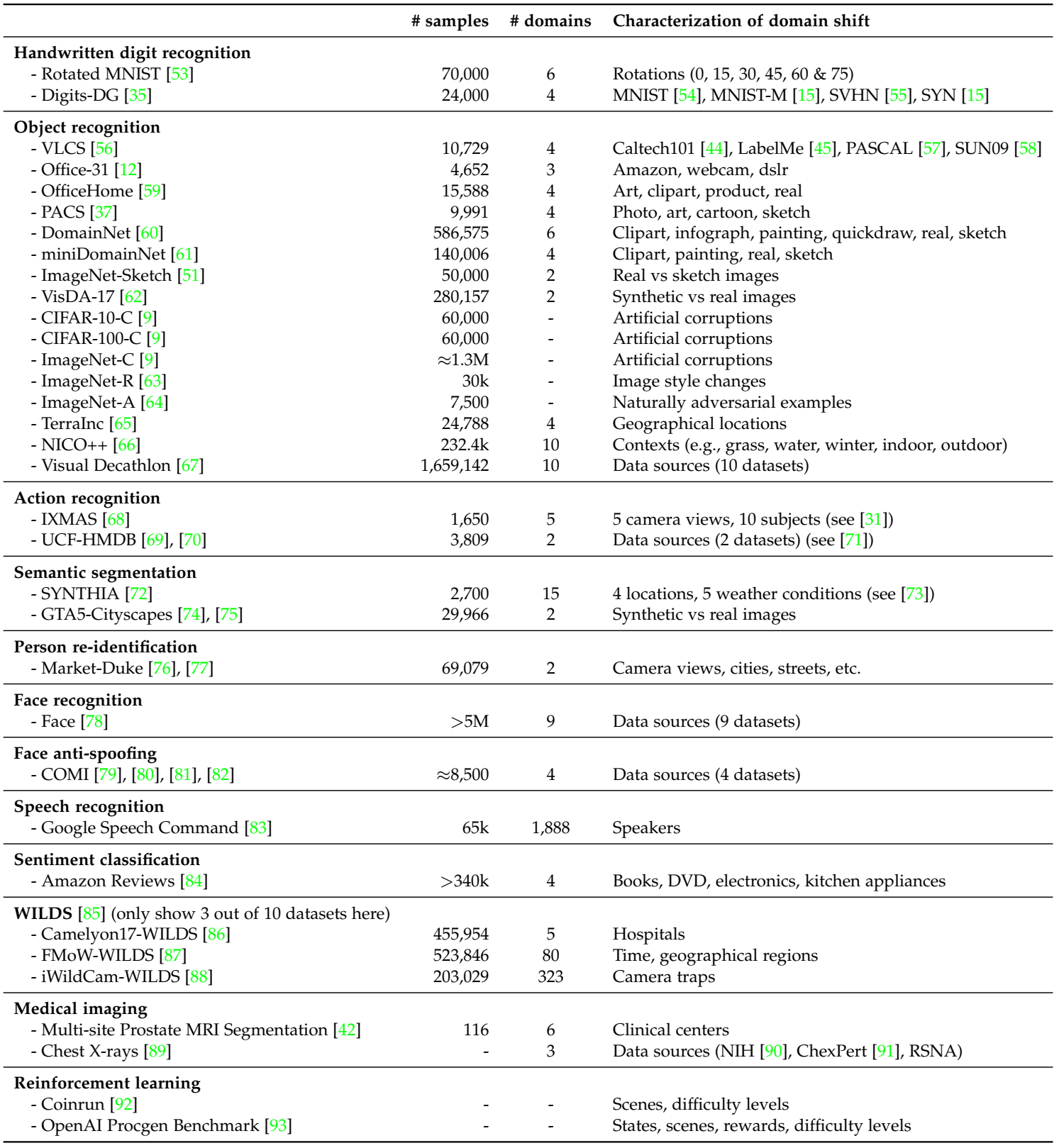

Datasets

Evalution

- 验证方法:有至少两个域,一个用于训练,剩下的用于测试

- 验证指标:使用各种领域的指标

- 模型选择:

Related Topics

- 监督学习:监督学习基于 iid 假设,DG 基于 ood(out-of-distribution) 假设

- 多任务学习:多任务学习希望模型能在一组任务取得较好效果而 DG 则是希望提高模型的泛化性能

- 迁移学习:迁移学习侧重知识的可迁移性,即学习一些“公共知识”,通常做的是上游的任务,而下游的目标域任务通常需要微调

- 零样本学习(ZSL): 大概是更侧重推理而不是泛化

- 域适应:会用目标域的数据,有域标签(其实多源域也会用到域标签)

- 测试时训练(TTT):介于域适应和域泛化之间的一种方法

Methodologies

域对齐

域对齐(Domain Alignment)是一种多源域中常用的方法,其中心思路是通过对不同源域的学习使得模型能学习到域不变的特征。

在域对齐的方法中,通常会借助各种各样的统计度量方法来减少域之间的距离。这些方法包括:

- 最小化动量

- 最小化对比损失

- 最小化KL散度

- 最小化最大平均差异(MMD, Maximum Mean Discrepancy)

- 域对抗学习

- 多任务学习

元学习

元学习即学会学习,最相关的是 MAML,将训练数据划分为元训练和元测试,先用元训练数据训练然后再用元测试数据提高性能。

其实没太懂,以后再补充一下

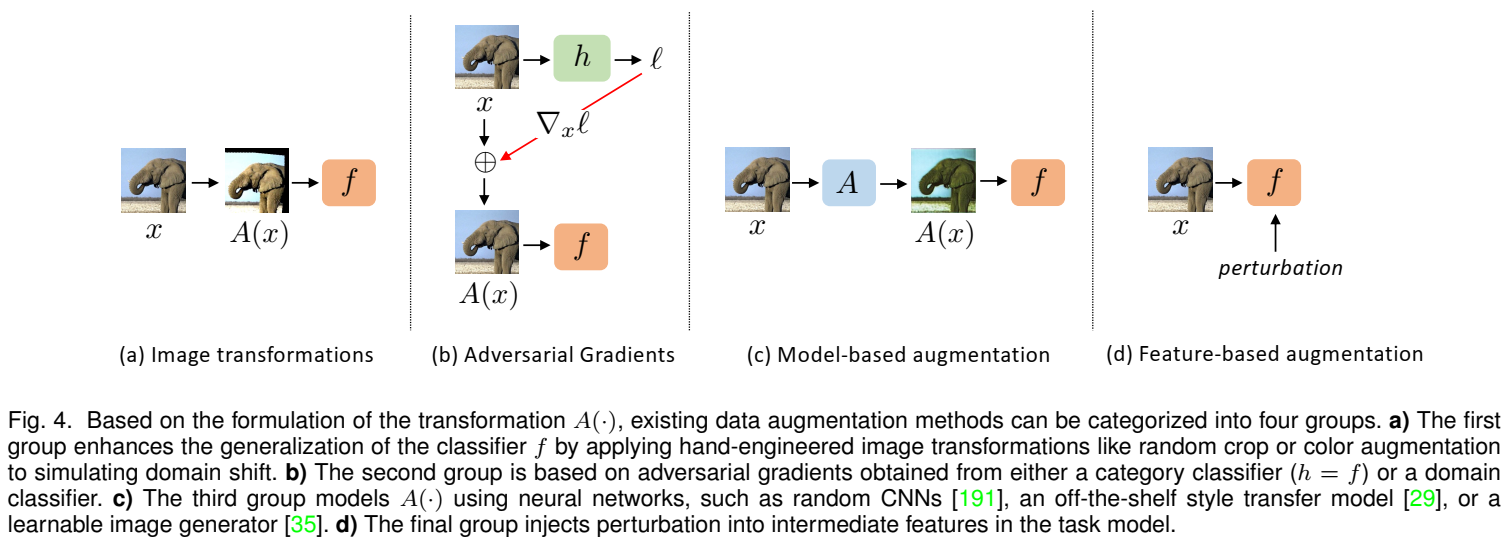

数据增强

大概可以分为四种:

集成学习

很传统很经典的做法了,核心思想就是多个模型投票或取平均,效果比单一模型推理要好。

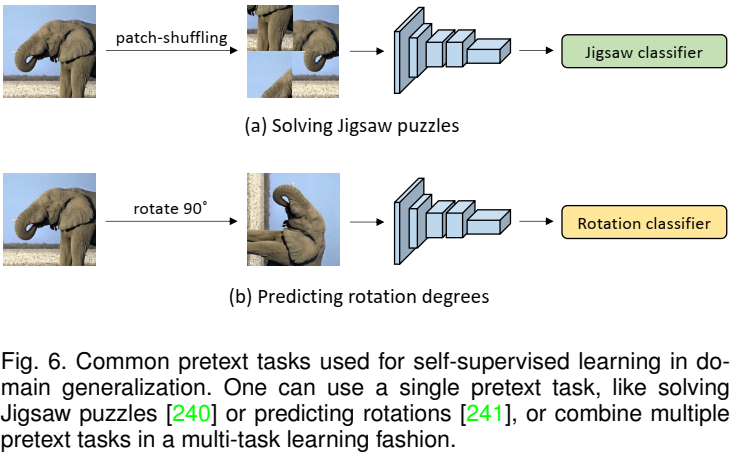

半监督学习

简单的解释就是说半监督可以学习到一些通用的特征而不管任务是什么,因此可以提高模型的泛化性能。

学习分解表示

主要思想是认为学习完全域不变的特征是困难的,可以适当进行一些放松,学习将域相关和域不变的特征进行解耦

正则化

核心观点是具有良好泛化能力的特征应该更关注于全局特征而非局部的细节特征,所以对模型进行一些约束来使得模型更关注全局特征而非一些域相关的细节特征,可以和很多其他 DG 方法联合使用。

强化学习

不太懂,跳过

Conclusion

结论,不足,展望以及其他文章对这项工作的评价

Others

未完待续

References

如果对你有帮助的话,请给我点个赞吧~

欢迎前往 我的博客 查看更多笔记